ウェブ検索をする際、「なんて検索すればいいだろう?」と悩んだ経験はないだろうか。例えば、道端で見かけた花の名前や犬の種類。その名前を知らなければ、「赤い花」や「もふもふした犬」としか検索しようがない。

そのようなシーンで活躍するのが「Google レンズ」。2019年10月、Google社はGoogle レンズに関するメディアセミナーを開催。そこでは、Googleグループ プロダクトマネージャー Lou Wang(ルー ワン)氏が、同サービスの仕組みや活用方法について語った。

本記事では、メディアセミナーの様子を交えながら、Googleレンズの仕組みと便利な活用法について紹介したい。

Googleレンズとは?

2017年にリリースされたGoogleレンズは、端的に言えば「身近なもの、目の前にあるものを調べることができるサービス」。カメラをかざし(もしくはすでに撮影されている写真でも可)、画像からさまざまな情報を読み取ることで、ユーザーに対し状況に応じた操作を実行してくれる。

例えば、冒頭で挙げた”名前の知らない花を見かけた時”。Googleレンズを使えば、その花にスマホのカメラを向けるだけで「何の花なのか」を知ることができる。

このサービスは、言語化することが難しいものを調べる際にとても重宝する。仮にウェブ上で「赤い花」と検索をしても、目の前にある花と同じものを探し当てるのには、かなりの時間を要するだろう。

そのようなシーンでGoogleレンズを使えば、一瞬にして「何の花か」に加え「どのような花か」まで情報を提供してくれる。そのため、「調べたくても調べ方がわからない」というような場面で、大いに活躍するサービスだ。

この2年間で精度がさらに向上 Googleレンズの仕組み

Googleグループ プロダクトマネージャー Lou Wang(ルー ワン)氏

Googleグループ プロダクトマネージャー Lou Wang(ルー ワン)氏

実は、iOS/Androidを問わず「Google アシスタント(Androidのみ)」「Google フォト」「Google検索(iOSのみ)」を使用している方であれば、すでにGoogleレンズを使用できる状態になっている。Android専用の「Google レンズ」アプリもリリースされているが、このアプリを使用せずとも恩恵を受けることが可能だ。

※ただし、Google フォトはすでに撮影した写真のみ対応。

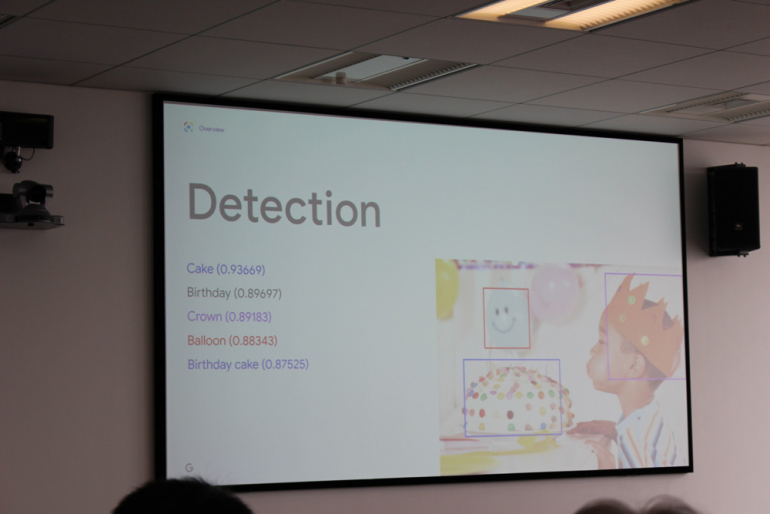

Google レンズは、以下の4つの技術により画像認識から情報提供までを行っている。

・Classification(分類)

・Detection(検出)

・Embeddings(分散表現)

・Model Training(モデル学習)

まず、数百万もの画像を利用した学習結果から、画像内のものを「ラベル化」。上の写真の例で言えば、Cake/Birthday/Crown/Balloon/Birthday cakeがラベル化され、そのラベルの「確からしさ」も数値で算出されている。

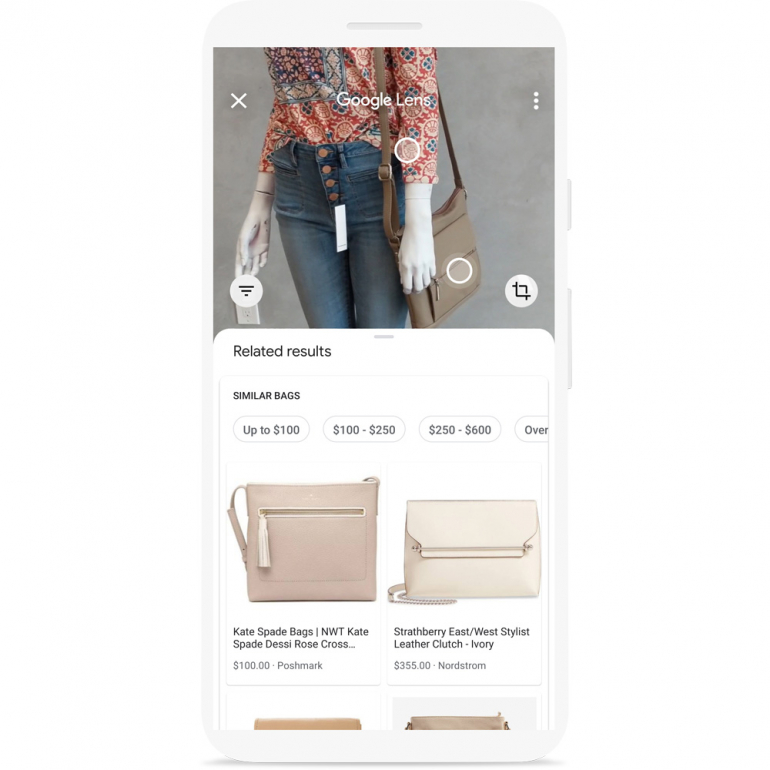

次に、画像内でそれらのオブジェクトが「どこにあるのか」を検出し、ユーザーに対し「ここに面白いものがある」と注意を促す。オブジェクトには○印が表示され、タップすることでそのまま情報の検索ができる仕組みだ。

さらに「Embeddings(分散表現)」の技術を用いることで、より正確な検索を実現し、似ている画像も表示してくれる。

従来は、モデル学習にGPU(Graphics Processing Unit)が用いられていたが、機械学習のために開発されたTPU(Tensor Processing Units)を導入したことで、数日〜数ヶ月を要した処理が数時間で完了するようになったという。

DIME MAGAZINE

DIME MAGAZINE