2025年9月26日、Googleから真に汎用的なロボットの実現に向けて、高度な思考力に基づいて自律的にタスクを遂行し、併せてエージェント体験を可能にする 2 つの新しいAIモデルが発表された。

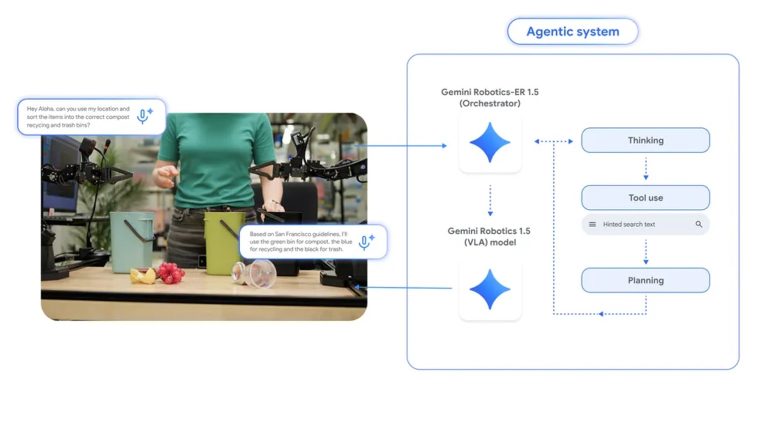

それが視覚・言語・行動 (VLA) モデルであるGemini Robotics 1.5と、視覚・言語モデル (VLM) であるGemini Robotics-ER 1.5だ。

以下、同社発表ブログをベースに、その概要をお伝えする。

「Gemini Robotics 1.5」と「Gemini Robotics-ER 1.5」について

Gemini Robotics 1.5 は視覚情報と指示を、ロボットがタスクを実行するための具体的な動作命令に変換。このモデルは、行動を起こす前に思考し、そのプロセスを可視化できる。

また、ロボットが複雑なタスクをより透明性の高い形で評価し、完了するのを支援する。そして複数の機体を横断して学習できるため、スキル習得を加速させる。

Gemini Robotics-ER 1.5 は物理世界について推論してネイティブにデジタルツールを呼び出し、ミッションを完了するための詳細な多段階の計画を作成する。

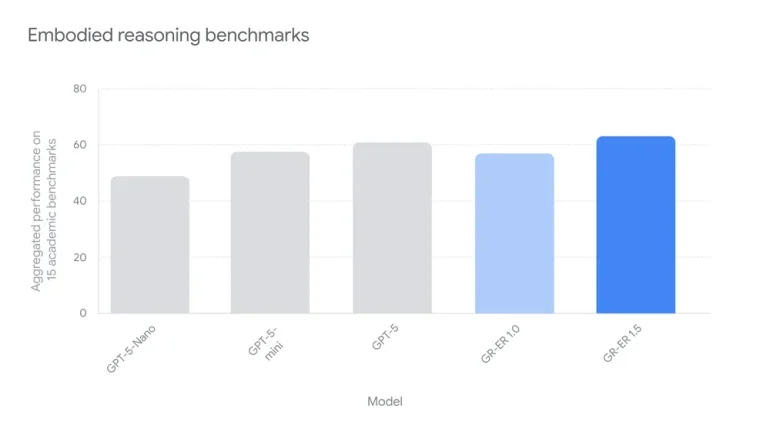

このモデルは現在、空間理解のベンチマーク全体で最先端のパフォーマンスを達成している。

9月26日より開発者は Google AI Studio を通じて、Gemini Robotics-ER 1.5 の利用が可能になった。Gemini Robotics 1.5 に関しては、現在一部のパートナー企業に提供が開始されている。

物理的なタスクのエージェント的な体験を可能に

我々の身の回りには、状況を読み解き、いくつもの手順を踏んで初めて完了できるタスクが溢れている。こうした複雑な作業は、現代のロボットにとって、依然として非常に困難な課題でもある。

例えば「この地域のルールに合わせて、目の前のゴミを分別して」とロボットに頼んだ場合、ロボットはまずインターネットで地域の分別ガイドラインを検索して、目の前のゴミが何であるかを認識することから始める必要があるからだ。

エンボディド・リーズニング モデル(身体性推論モデル: 実世界における物理的な状況を理解し推論する能力)であるGemini Robotics-ER 1.5は、ロボット全体の頭脳のように機能し、全ての活動を統括する。

そして、Gemini Robotics-ER 1.5 は導き出した計画をステップごとに自然言語の指示に変換して、Gemini Robotics 1.5 へと伝える。指示を受けたGemini Robotics 1.5 は、その優れた視覚と言語の理解能力を用いて、具体的なアクションを直接実行に移す。

さらにこのモデルは、自らの行動について思考することで、意味が複雑なタスクをより巧みに解決するだけでなく、その思考プロセスを人間に言葉で説明することもできる。これにより、ロボットの意思決定の透明性が高まっていく。

こうして両モデルが連携することでゴミの分別という作業もこなせるようになるという。

これら両モデルは、中核となるGeminiモデルファミリーを基盤としており、それぞれの役割に特化するよう異なるデータセットでファインチューニングされている。これらを連携させることで、ロボットがより長いタスクや多様な環境に汎化する能力が高まる。

■関連動画はこちらから

現実世界への理解力

Gemini Robotics-ER 1.5は、エンボディド推論に特化して最適化された、初めての思考モデルだ。テスターの協力を得たプログラムを通じて、現実世界の様々なユースケースを反映させて開発された。

その結果、学術的なベンチマークと社内の独自ベンチマークの両方において、最先端のパフォーマンスを達成している。

行動を起こす前に自ら思考する

従来の視覚・言語・行動モデルは、与えられた指示や計画を、そのままロボットの動きに直接的に変換するのみだった。

それに対してGemini Robotics 1.5 は、単に指示を変換するだけでなく、行動を起こす前に自ら思考することができる。つまり、複数の手順や深い意味の理解が求められるタスクに対し、まず自然言語で内的な推論と分析、つまり思考プロセスを組み立て、その上で行動に移すことが可能なのだ。

例えば、「洗濯物を色分けして」というタスクを与えられた場合、次のようにロボットは異なるレベルで思考する。

最初に「色分け」とは白い服は白いカゴへ、それ以外の色の服は黒いカゴへ入れることだと、タスク全体の目的を理解する。次に、「赤いセーターを拾い上げ、黒いカゴに入れる」といった具体的なステップを考え、さらには「セーターを掴みやすくするために、一度手前に引き寄せる」など、各ステップを実行するための細かな動作レベルまで考える。

■関連動画はこちらから

この多層的な思考プロセスを通じて、視覚・言語・行動モデルは、より長いタスクを、ロボットが確実に実行できるような、よりシンプルで短い単位へと分解することを自ら判断を行なう。

さらに、こうした能力は、モデルが未知のタスクに対応する能力や、周囲の環境変化に対する堅牢性を高める上でも重要な役割を果たす。

■異なる機体に対応

ロボットは形状、サイズ、センサー、関節の自由度などが一体一体すべて異なるため、あるロボットで学習したスキルを別のロボットに応用することは、これまで大きな課題となっていた。

これに対してGemini Robotics 1.5は、異なる機体(エンボディメント)を横断して学習する顕著な能力を有している。つまり新しい機体ごとにモデルを特化させる必要なく、あるロボットで学習した動きを別のロボットに移転できるのだ。

この飛躍的な進化は、ロボットが新しいスキルを習得するスピードを加速させ、その知性と実用性をさらに高いレベルへと引き上げていく。

実際に、トレーニングでは ALOHA 2 ロボットにのみ提示されたタスクが、Apptronik社のヒューマノイドロボットApollo や Franka ロボットでもそのまま機能すること、その逆も同様であることを確認している。

■関連動画はこちらから

AIとロボット工学の責任ある発展のための取り組み

エンボディド AI が持つ大きな可能性を解き放つと同時に、Googleでは「安全性の確保を最優先事項として捉えています」と表明。自ら思考し行動する エージェントAI としてのロボットが、人間中心の社会で責任ある形で活用される未来を見据え、安全性とアライメントに関する新たなアプローチを積極的に開発していると説明している。

この取り組みを確かなものにするため、専門組織であるResponsibility & Safety Council (RSC) や Responsible Development & Innovation (ReDI) チームがロボティクスチームと緊密に連携し、開発されるすべてのモデルが Google のAI 原則を遵守するよう徹底しているという。

Gemini Robotics 1.5は、高度な意味論的推論を通じて、安全性への多角的なアプローチを実装している。

具体的には、行動を起こす前にまず安全性を自ら思考すること、GoogleのGemini Safety Policies に準拠し人間との敬意ある対話を保つこと、そして必要に応じて衝突回避などの物理的な安全サブシステムを作動させることなどが含まれている。

■物理世界における AGI の実現に向けた一歩

Googleでは今回の発表に際して、次のようにコメントしている。

「Gemini Robotics 1.5 は、物理世界における AGI の実現に向けた一歩です。単にコマンドに反応するだけのモデルから、自ら推論し、計画を立て、ツールを使いこなし、そして未知の状況にも対応(汎化)する自律的なシステムの構築を目指します。

これは、ロボットが知性と器用さを兼ね備え、物理世界の複雑さを乗り越え、最終的には私たちの生活においてより役立ち、統合された存在となるロボットを構築するための基礎的な一歩です。

私たちは、広範な研究コミュニティの皆様と共にこの探求を続けられることを大変嬉しく思います。そして、ロボティクス コミュニティにいる皆様が、最新の Gemini Robotics-ERモデルを使ってどのような未来を創造するのか、心から楽しみにしています」

関連情報

https://blog.google/intl/ja-jp/company-news/technology/gemini-robotics-15-ai/

構成/清水眞希

DIME MAGAZINE

DIME MAGAZINE