ライブ翻訳やImage PlaygroundのアップデートなどWWDC25で発表された「Apple Intelligence」の主な新機能まとめ

2025.06.12

アップルは現地時間2025年6月9日から6月13日までカリフォルニア州クパチーノの本社で開催中の年次開発者会議、「WWDC25(Worldwide Developers Conference 2025)」においてApple Intelligenceの新機能を発表した。

なおApple Intelligenceの機能は、6月9日よりテスト用に提供され、対応するデバイスで対応する言語に設定しているユーザーは今秋から利用できるようになる。

そしてApple Intelligenceの機能は年末までに、デンマーク語、オランダ語、ノルウェー語、ポルトガル語(ポルトガル)、スウェーデン語、トルコ語、中国語(繁体字)、ベトナム語という8つの新しい言語に対応する予定だ。

言語の壁を打ち破るライブ翻訳

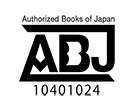

ユーザーの前に言語の壁が立ち塞がった時は、ライブ翻訳を利用すれば、メッセージの送信や会話の際に言語をまたいでコミュニケーションをとることができる。

この体験は、メッセージ、FaceTime、電話に組み込まれるもので、Appleが構築した完全にデバイス上で動作するモデルによって実現するため、ユーザーの個人的な会話のプライバシーも守られる。

メッセージアプリでは、ライブ翻訳がメッセージを自動的に翻訳を行なう。海外旅行中に新しく知り合った友人と計画を立てている時にも、ユーザーがメッセージを入力すれば翻訳され、相手が希望する言語で送信でき、返信を受け取った時も、それぞれのメッセージはすぐに翻訳される(2)。

2:メッセージのライブ翻訳は、日本語、英語(米国、英国)、フランス語(フランス)、ドイツ語、イタリア語、韓国語、ポルトガル語(ブラジル)、スペイン語(スペイン)、中国語(簡体字)に対応している。

FaceTimeでは、話し手の声を聞きながら、翻訳されたライブキャプションによって会話についていくことが可能。また、電話の通話では、会話の全体を通して、翻訳が音声で読み上げられる(3)。

3:電話とFaceTimeのライブ翻訳は、一対一の通話の場合に、英語(米国、英国)、フランス語(フランス)、ドイツ語、ポルトガル語(ブラジル)、スペイン語(スペイン)に対応している。

ライブ翻訳を利用すれば、ユーザーはメッセージでタイプ入力する時も、FaceTimeや電話で話す時も、言語をまたいでコミュニケーションをとることができる。

ライブ翻訳を利用すれば、ユーザーはメッセージでタイプ入力する時も、FaceTimeや電話で話す時も、言語をまたいでコミュニケーションをとることができる。

■ジェン文字とImage Playgroundのアップデートにより新たな方法で創造性を発揮

ジェン文字とImage Playgroundは、ユーザーにさらに多くの自己表現の方法を提供すれう。テキストによる説明をジェン文字に変換するだけでなく、絵文字を取り入れ、それらを説明と組み合わせることによって、新しいものを作り出せるようになる。

ジェン文字やImage Playgroundを使用して、家族や友人からインスピレーションを得た画像を作成する際、ユーザーは表現方法を変更したり、例えば友人の最新の見た目に合わせてヘアスタイルを変えるなど、個人の特徴を調整することも可能だ。

Image Playgroundでは、ChatGPTによって油絵風やベクターアートなどのまったく新しいスタイルを利用できる。具体的なアイデアが浮かんだら、ユーザーは「任意のスタイル」をタップして自分の希望を説明することができる。

Image Playgroundはユーザーの説明や写真をChatGPTに送り、ユニークな画像を作成する。管理の権限は常にユーザーにあり、ユーザーが許可しない限りChatGPTには何も共有されない。

具体的なアイデアが浮かんだ時のために、Image PlaygroundとChatGPTによる「任意のスタイル」オプションなどの新しいスタイルが登場する。

具体的なアイデアが浮かんだ時のために、Image PlaygroundとChatGPTによる「任意のスタイル」オプションなどの新しいスタイルが登場する。

AIはライターの味方?話題のApple Intelligenceで「書く」仕事はどう変わるのか

ついに日本語対応が始まったApple Intelligence。iPhone 16eに機種変更したばかりの筆者にとっては、非常に喜ばしい出来事である。 だが、A...

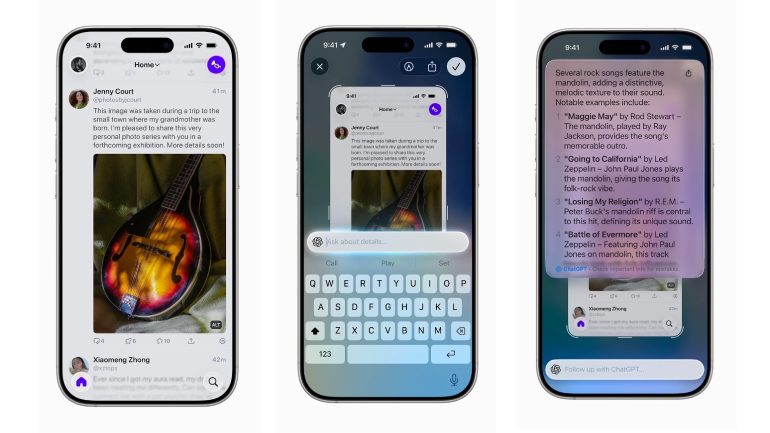

ユーザーの検索や操作に役立つビジュアルインテリジェンス

Apple Intelligenceを基盤とするビジュアルインテリジェンスがユーザーのiPhoneの画面に拡張され、ユーザーはあらゆるアプリで、画面上に表示しているものを検索し操作できる。

Apple Intelligenceのアップデートで、ビジュアルインテリジェンスがユーザーのiPhoneの画面上に表示されているコンテンツに拡張され、GoogleやEtsyなどの対応アプリを使って似たようなものを探すといった操作が可能になる。

Apple Intelligenceのアップデートで、ビジュアルインテリジェンスがユーザーのiPhoneの画面上に表示されているコンテンツに拡張され、GoogleやEtsyなどの対応アプリを使って似たようなものを探すといった操作が可能になる。

ビジュアルインテリジェンスはすでに、ユーザーがiPhoneのカメラを使用して周囲の対象物や場所について学ぶのに役立っているが、これからはiPhoneの画面上に表示されているものについて、より多くのことを、より速く実行できるようになる。

ユーザーは画面上で見ているものについてChatGPTに質問して詳しい情報を得たり、GoogleやEtsyなどの対応アプリで検索して類似の画像や製品を見つけることが可能になる。

例えばランプなど、特に興味を惹かれるものが表示されている場合、ユーザーはそれをハイライトし、同じものや似たようなものをオンラインで検索することができる。

ビジュアルインテリジェンスによって、ユーザーは特定の対象物についての詳細をChatGPTに質問することができる。

ビジュアルインテリジェンスによって、ユーザーは特定の対象物についての詳細をChatGPTに質問することができる。

ビジュアルインテリジェンスは、イベントが表示されていることを認識してカレンダーへの追加を提案(4)。Apple Intelligenceが関連するデータを抽出してイベントを作成する。

4:ビジュアルインテリジェンスでイベントをカレンダーに追加する機能は、iPhone 16の全モデル、iPhone 15 Pro、iPhone 15 Pro Maxで、英語で利用できる。

ビジュアルインテリジェンスは、イベントが表示されていることを認識してカレンダーへの追加を提案し、Apple Intelligenceが関連するデータを抽出してイベントを作成する。

ビジュアルインテリジェンスは、イベントが表示されていることを認識してカレンダーへの追加を提案し、Apple Intelligenceが関連するデータを抽出してイベントを作成する。

ユーザーは、スクリーンショットを撮るのと同じボタンを押すだけで、画面上に表示されているものに関してビジュアルインテリジェンスを利用できる。

ユーザーはスクリーンショットを保存または共有するか、ビジュアルインテリジェンスを使用してさらに別の操作を行うかを選択する。

■Apple IntelligenceがApple Watchのフィットネスに拡張

Workout Buddyは、Apple Intelligenceを利用した、ほかに類を見ないApple Watchのワークアウト体験で、ユーザーのワークアウトのデータとフィットネス履歴を取り込み、パーソナライズされた、モチベーションを高める洞察をセッション中に生成する(5)。

5:Workout Buddyは、Apple Watch Series 6以降、Apple Watch SE(第2世代)、Apple Watch UltraおよびUltra 2をApple Intelligence対応のiPhoneと使用する場合に、まずは英語で利用できるようになる。

有意義なインスピレーションをリアルタイムで提供するため、Workout Buddyは心拍数、ペース、距離、アクティビティリング、個人のフィットネスマイルストーンなどのデータにもとづき、ユーザーの現在のワークアウトやフィットネス履歴から得たデータを分析。

そのあと新しいテキスト読み上げモデルが、Fitness+トレーナーの音声データを使用して構築されたダイナミックな生成音声に洞察を変換する。

そのため音声は、ワークアウトに合ったエネルギー、スタイル、トーンになる。Workout Buddyはこのデータを、Apple Intelligenceを用いてプライバシーとセキュリティを保護しながら処理を行なう。

Workout Buddyは、Bluetoothヘッドフォンを接続したApple Watchで利用でき、Apple Intelligence対応のiPhoneが近くにあることが必要だ。

屋外および屋内のランニング、屋外および屋内のウォーキング、屋外のサイクリング、高強度インターバルトレーニング、機能的および従来型筋力トレーニングなど、人気の高いワークアウトの種類の一部において、まずは英語で利用できるようになる。

■Apple Intelligenceのデバイス上のモデルがデベロッパも利用可能に

Appleは、Apple Intelligenceの中核にあるデバイス上の基盤モデルをどのアプリからでも直接利用できるようにした。

基盤モデルフレームワークを利用すれば、アプリのデベロッパはApple Intelligenceをベースに、無料のAI推論を利用して、インテリジェントで、オフラインでも利用でき、プライバシーが保護される新たな体験をユーザーに提供できるようになる。

例えば教育アプリなら、デバイス上のモデルを利用して、クラウドAPIの費用をかけることなく、ユーザーのメモをもとにパーソナライズされたクイズを作成でき、アウトドアアプリなら、ユーザーがオフラインの時にも使える自然な言葉づかいでの検索機能を追加できる。

このフレームワークはSwiftにネイティブ対応しているため、アプリのデベロッパはたった3行のコードでApple Intelligenceのモデルに簡単にアクセスできる。

ガイド付きの生成やツールの呼び出しなどがすべてこのフレームワークに含まれているので、デベロッパの既存アプリに生成機能を組み込むことが、かつてないほど容易になる。

■ショートカットがさらに賢く

ショートカットがこれまで以上にパワフルで賢く進化した。ユーザーは、Apple Intelligenceによって実現したまったく新しい一連のショートカットであるインテリジェントなアクションを利用することが可能。作文ツールによるテキストの要約や、Image Playgroundによる画像の生成などの機能に対応する専用のアクションが提供される。

ユーザーはデバイス上で、またはプライベートクラウドコンピューティングによって、Apple Intelligenceのモデルを直接利用して、ショートカット内で利用される情報のプライバシーを保ったまま、ほかのショートカットに送るレスポンスを生成できるようになる。

例えば学生なら、Apple Intelligenceのモデルを利用して授業の音声の文字起こしと自分がとったノートの内容を比較し、書き取れていない重要項目があれば追加する、というショートカットを作成できる。

また、ユーザーはショートカットに送るレスポンスを、ChatGPTを利用して生成することも可能だ。

ショートカットにApple Intelligenceの驚異的なパワーが搭載されたことで、ユーザーはデバイス上で、またはプライベートクラウドコンピューティングによって、Apple Intelligenceのモデルを直接利用し、ほかのショートカットに送るレスポンスを生成できるようになる。

ショートカットにApple Intelligenceの驚異的なパワーが搭載されたことで、ユーザーはデバイス上で、またはプライベートクラウドコンピューティングによって、Apple Intelligenceのモデルを直接利用し、ほかのショートカットに送るレスポンスを生成できるようになる。

提供について

これらの新機能はすべて、本日よりhttps://developer.apple.com/jp/でApple Developer Programを通じてテスト用に提供される。パブリックベータ版は来月、https://beta.apple.com/jaでApple Beta Software Programを通じて提供される。

対応するデバイスでApple Intelligenceを有効にし、対応言語に設定しているユーザーは、今秋からアクセスできるようになる。対応するデバイスにはiPhone 16の全モデル、iPhone 15 Pro、iPhone 15 Pro Max、iPad mini(A17 Pro)、M1以降を搭載したiPadとMacのモデルが含まれる。

Siriとデバイスの言語は同じ対応言語に設定する必要がある。対応言語は日本語、英語、フランス語、ドイツ語、イタリア語、ポルトガル語(ブラジル)、スペイン語、韓国語、または中国語(簡体字)。今年の年末までに、さらに多くの言語が対応する予定だ。

これには、デンマーク語、オランダ語、ノルウェー語、ポルトガル語(ポルトガル)、スウェーデン語、トルコ語、中国語(繁体字)、ベトナム語が含まれる。言語や地域によっては一部の機能を利用できない場合があります。また、利用できる機能は、現地の法律や規制によって異なる場合もある。詳しくは、https://www.apple.com/jp/apple-intelligence/をチェックしていただきたい。

構成/清水眞希

DIME MAGAZINE

DIME MAGAZINE